"Capturer la prosodie musicale par le biais d'annotations audiovisuelles interactives".

Daniel Bedoya, doctorant de Sorbonne Université et bénéficiaire d'une contrat EDITE, a réalisé sa thèse intitulée "Capturer la prosodie musicale par le biais d'annotations audiovisuelles interactives" au sein de l'équipe Représentations musicales du laboratoire STMS (Ircam-Sorbonne Université-CNRS-Ministère de la Culture). Sa thèse a pu bénéficier de financements par le projet ERC COSMOS (Computational Shaping and Modeling of Musical Structures) au sein du Laboratoire STMS et par le Contrat ATER au CNAM, Laboratoire LMSSC.

La soutenance aura lieu à l'Ircam, en anglais, devant le jury qui sera composé de :

- Roberto Bresin, KTH Royal Institute of Technology (Suède), Rapporteur

- Pierre Couprie, Université Paris-Saclay, Rapporteur

- Jean-Julien Aucouturier, FEMTO-ST, Examinateur

- Louis Bigo, Université de Lille, Examinateur

- Muki Haklay, University College London, Royaume-Uni, Examinateur

- Anja Volk, Utrecht University, Pays-Bas, Examinateur

- Carlos Agón, Sorbonne Université, Directeur

- Elaine Chew, King's College London, Royaume-Uni, Co-directrice

Il sera aussi possible de la suivre en direct sur la chaîne Youtube de l'Ircam https://youtube.com/live/Agq2iZw1ZxY

Résumé

Des projets de science participative (SP) ont stimulé la recherche dans plusieurs disciplines au cours des dernières années. Des citoyens scientifiques contribuent à cette recherche en effectuant des tâches cognitives, favorisant l'apprentissage, l'innovation et l'inclusion. Bien que le crowdsourcing ait servi à recueillir des annotations structurelles en musique, la SP reste sous-utilisée pour étudier l'expressivité musicale.

Nous introduisons un nouveau protocole d'annotation pour capturer la prosodie musicale, associée aux variations acoustiques introduites par les interprètes pour rendre la musique expressive. Notre méthode descendante, centrée sur l'humain, donne la priorité à l'auditeur dans la production d'annotations des fonctions prosodiques de la musique. Nous nous concentrons sur la segmentation et la proéminence, qui véhiculent la structure et l'affect. Ce protocole fournit un cadre de SP et une approche expérimentale pour réaliser des études systématiques et extensibles.

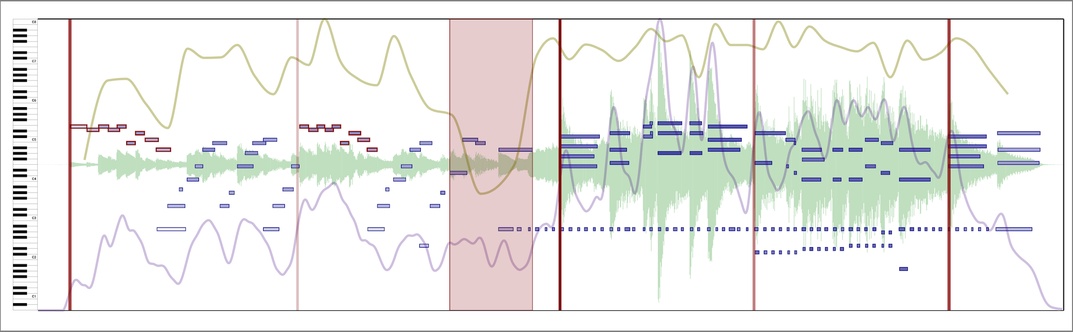

Nous mettons en œuvre ce protocole d'annotation dans CosmoNote, un logiciel web personnalisable, conçu pour faciliter l'annotation de structures musicales expressives. CosmoNote permet aux utilisateurs d'interagir avec des couches visuelles, y compris la forme d'onde, les notes enregistrées, les attributs audio extraits et les caractéristiques de la partition. Nous pouvons placer des frontières de niveaux différents, des régions, des commentaires et des groupes de notes.

Nous avons mené deux études visant à améliorer le protocole et la plateforme. La première examine l'impact des stimuli auditifs et visuels simultanés sur les frontières de segmentation. Nous comparons les différences dans les distributions de frontières dérivées d'informations intermodales (auditives et visuelles) et unimodales (auditives ou visuelles). Les distances entre les distributions unimodales-visuelles et intermodales sont plus faibles qu'entre les distributions unimodales-auditives et intermodales. Nous montrons que l'ajout de visuels accentue les informations clés et fournit un échafaudage cognitif aidant à marquer clairement les frontières prosodiques, bien qu'ils puissent détourner l'attention de structures spécifiques. À l'inverse, sans audio, la tâche d'annotation devient difficile, masquant des indices subtils. Malgré leur exagération ou inexactitude, les repères visuels sont essentiels pour guider les annotations de frontières en interprétation, ce qui améliore les résultats globaux.

La deuxième étude utilise tous les types d'annotations de CosmoNote et analyse comment les participants annotent la prosodie musicale, avec des instructions minimales ou détaillées, dans un cadre d'annotations libres. Nous comparons la qualité des annotations entre musiciens et non-musiciens. Nous évaluons la composante de SP dans un cadre écologique où les participants sont totalement autonomes dans une tâche où le temps, l'attention et la patience sont valorisés. Nous présentons trois méthodes basées sur des étiquettes d'annotation, des catégories et des propriétés communes pour analyser et agréger les données. Les résultats montrent une convergence dans les types d'annotations et les descriptions utilisées pour marquer les éléments musicaux récurrents, pour toute condition expérimentale et aptitude musicale. Nous proposons des stratégies pour améliorer le protocole, l'agrégation des données et l'analyse dans des applications à grande échelle.

Cette thèse enrichit la représentation et la compréhension des structures en musique interprétée en introduisant un protocole et une plateforme d'annotation, des expériences adaptables et des méthodes d'agrégation et d'analyse. Nous montrons l'importance du compromis entre l'obtention de données plus simples à analyser et celle d'un contenu plus riche, capturant une pensée musicale complexe. Notre protocole peut être généralisé aux études sur les décisions d'interprétation afin d'améliorer la compréhension des choix expressifs dans l'interprétation musicale.